数据工程师的“最后一公里”

作为一名数据工程师,我经常处理“大”数据。但有时候也需要处理“小”数据。比如通过大数据计算得到的一些相对“小”的数据结果,还需要进一步的统计分析。如果再用大数据的框架跑一遍计算,非常浪费资源浪费时间。效率最高的方法还是在本地就把这些数据处理了。

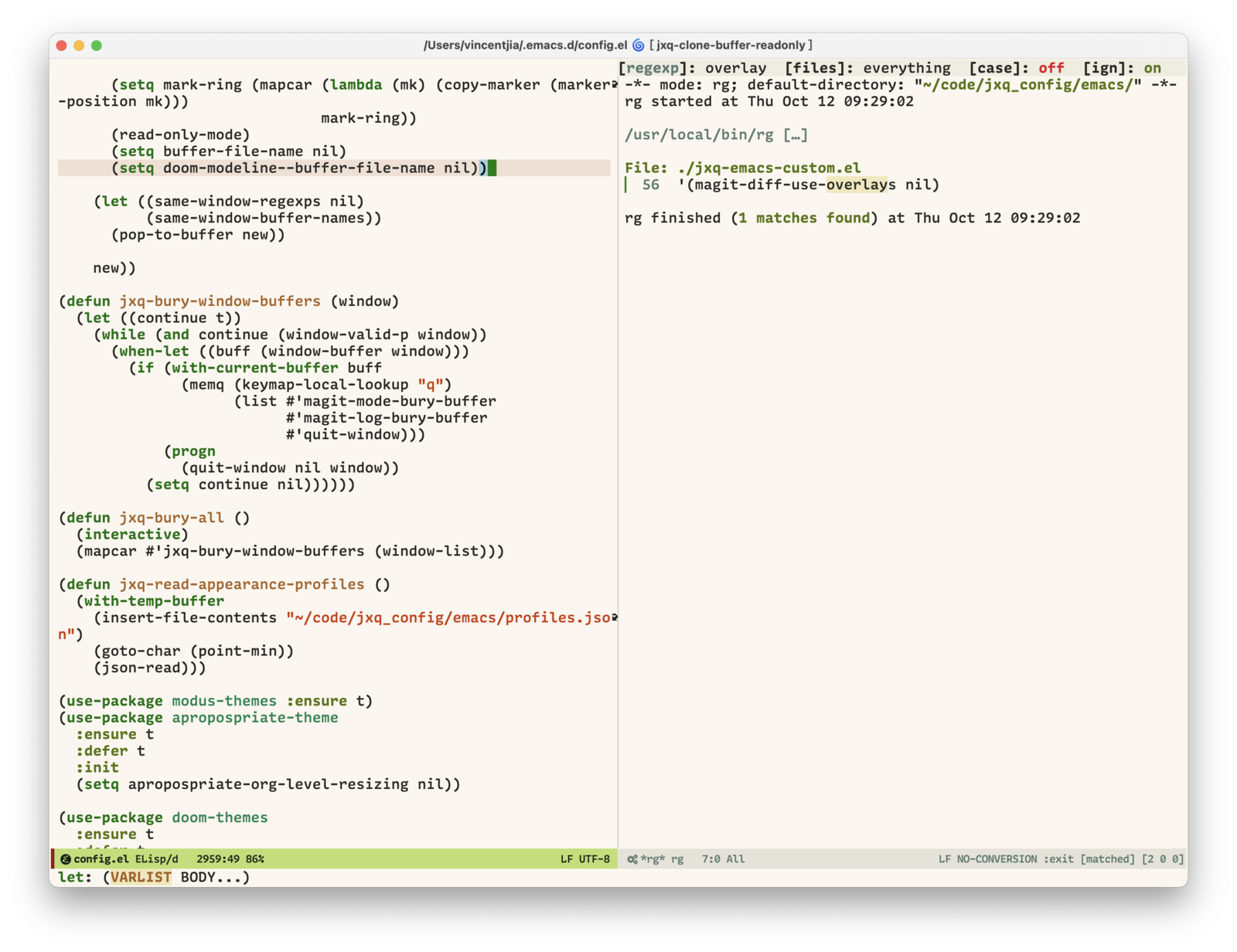

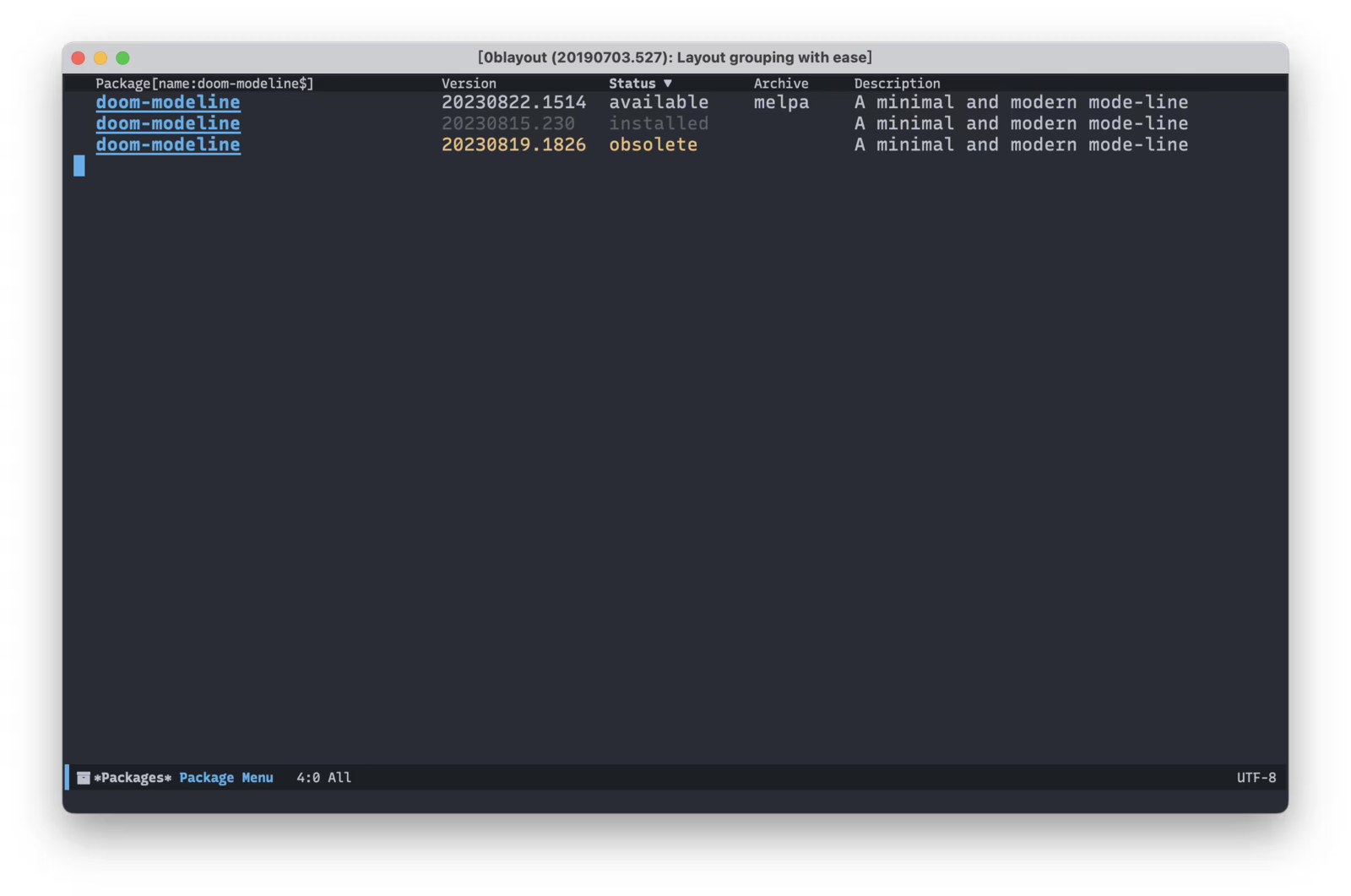

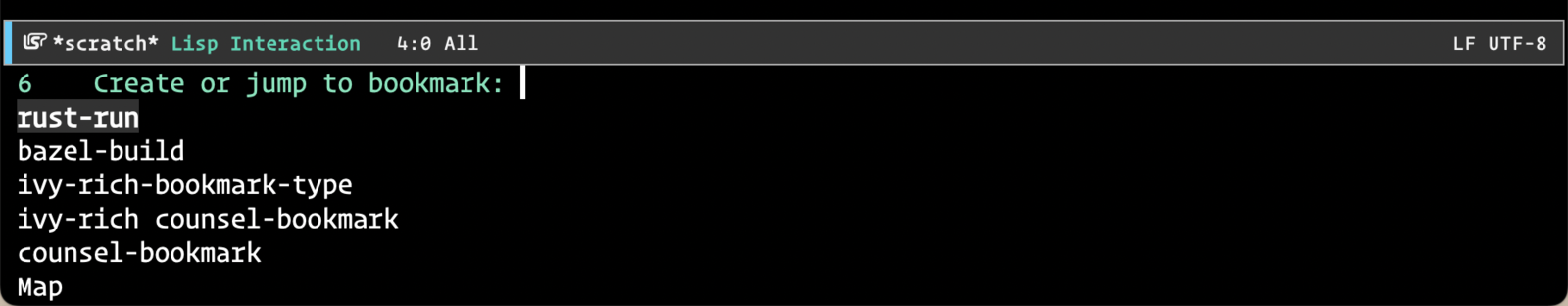

这类数据处理场景就像送快递,包裹跨越万水千山终于到了目的地城市。这时候应该选择什么交通工具来把快递送到你的手上呢?长途和短途所选择的交通工具肯定是有差别的。在这种“小数据”的场景下,什么工具才是效率最高的?为了解决数据分析领域的“最后一公里”问题,我尝试了很多种工具,但总觉得不太顺手。因此实现了 ob-pyspark-sql 这个 org-mode 扩展包,解决自己的痛点,提升工作效率。